La IA és la tecnologia més poderosa que ha creat mai la humanitat, perquè és la primera tecnologia que pot prendre decisions i crear noves idees per si mateixa. Una bomba atòmica no pot decidir a qui atacar ni pot inventar noves bombes ni noves estratègies militars. En canvi una IA pot decidir per si mateixa atacar un objectiu concret, pot inventar noves bombes, noves estratègies i fins i tot noves IA. El més important que cal tenir en compte de la IA és que no és una eina a les nostres mans, és un agent autònom.

Per descomptat, encara definim els objectius que les IA han d’aconseguir. Però el problema és que, en la recerca dels objectius que han de perseguir, una IA podria adoptar subobjectius i estratègies imprevistes que podrien tenir conseqüències inesperades i potencialment molt nocives. Per exemple, en els darrers anys, empreses de xarxes socials com ara Facebook, YouTube i Twitter van donar als seus algoritmes d’IA un objectiu senzill i en principi inofensiu: augmentar la participació dels usuaris. Com més temps passaven els usuaris a les xarxes socials, més diners guanyaven aquestes empreses.

Però en la recerca de l’objectiu d’«augmentar la participació dels usuaris», els algoritmes van fer una descobriment sinistre. Experimentant amb milions de conillets d’índies humans, els algoritmes van aprendre que la indignació augmenta la participació i implicació dels usuaris. Si pots prémer el botó de la ira, la por o l’odi en un cervell humà, captes l’atenció d’aquell humà i els mantens enganxat a la pantalla. Així doncs, els algoritmes van començar a difondre indignació deliberadament, que és una de les causes principals de l’actual epidèmia de teories de la conspiració, fake news, i disturbis socials que minen les democràcies arreu del món.

Els directius de Facebook, YouTube i Twitter no pretenien això. Van pensar que si augmentava la implicació dels usuaris augmentarien els seus propis guanys, i no van preveure que també augmentaria el caos social. Aquest desastre social va ser fruit d’un desalineament entre els interessos profunds de les societats humanes i les estratègies adoptades per les IA. En argot professional això es coneix com a «problema d’alineament». Quan assignem un objectiu a un agent d’IA, com podem estar segurs que les estratègies que adoptarà estaran realment alineades amb els nostres interessos finals?

No cal dir que el problema de l’alineament no és nou ni exclusiu de les IAs. Ha turmentat la humanitat durant milers d’anys abans de la invenció dels ordinadors. Ha estat, per exemple, el problema fonamental del pensament militar modern, recollit en la teoria de la guerra de Carl von Clausewitz, un general prussià que va lluitar durant les guerres napoleòniques. Al seu llibre De la guerra (1832-1834), Clausewitz va crear un model racional per entendre la guerra, i encara avui és la teoria militar dominant. La seva màxima més important és que «la guerra és la continuació de la política amb altres mitjans». Això implica que la guerra no és un esclat emocional, una aventura heroica o un càstig diví. La guerra no és ni tan sols un fenomen militar. És més aviat una eina política. Segons Clausewitz, les accions militars i fins i tot les victòries militars són completament irracionals tret que estiguin alineades amb algun objectiu polític general.

La història està plena de victòries militars decisives que van provocar desastres polítics. Per a Clausewitz, l’exemple més evident va ser la carrera de Napoleó. La seva sèrie de victòries van fer que obtingués el control temporal de territoris immensos, però això no li va garantir èxits polítics duradors. Les seves conquestes militars només van empènyer la majoria de les potències europees a unir-se contra ell, i el seu imperi es va esfondrar una dècada després d’haver estat coronat emperador.

Un exemple més recent de victòria militar que va conduir a la derrota política va ser la invasió nord-americana de l’Iraq el 2003. Els nord-americans van guanyar totes les batalles militars importants, però no van aconseguir assolir cap dels seus objectius polítics a llarg termini. La seva victòria militar no va establir un règim amic a l’Iraq ni un ordre geopolític favorable a l’Orient Mitjà. El veritable guanyador de la guerra va ser l’Iran. La victòria militar nord-americana va convertir l’Iraq, que era l’enemic tradicional de l’Iran, en el seu vassall, i així va debilitar molt la posició nord-americana a l’Orient Mitjà i alhora va convertir l’Iran en el país hegemònic de la regió.

Tant Napoleó com George W. Bush van ser víctimes del problema de l’alineament. Les seves estratègies militars a curt termini no estaven alineats amb els objectius geopolítics a llarg termini dels seus països. Podem entendre el De la guerra de Clausewitz com una advertència que «maximitzar la victòria militar» és un objectiu tan miop com «maximitzar el compromís dels usuaris».

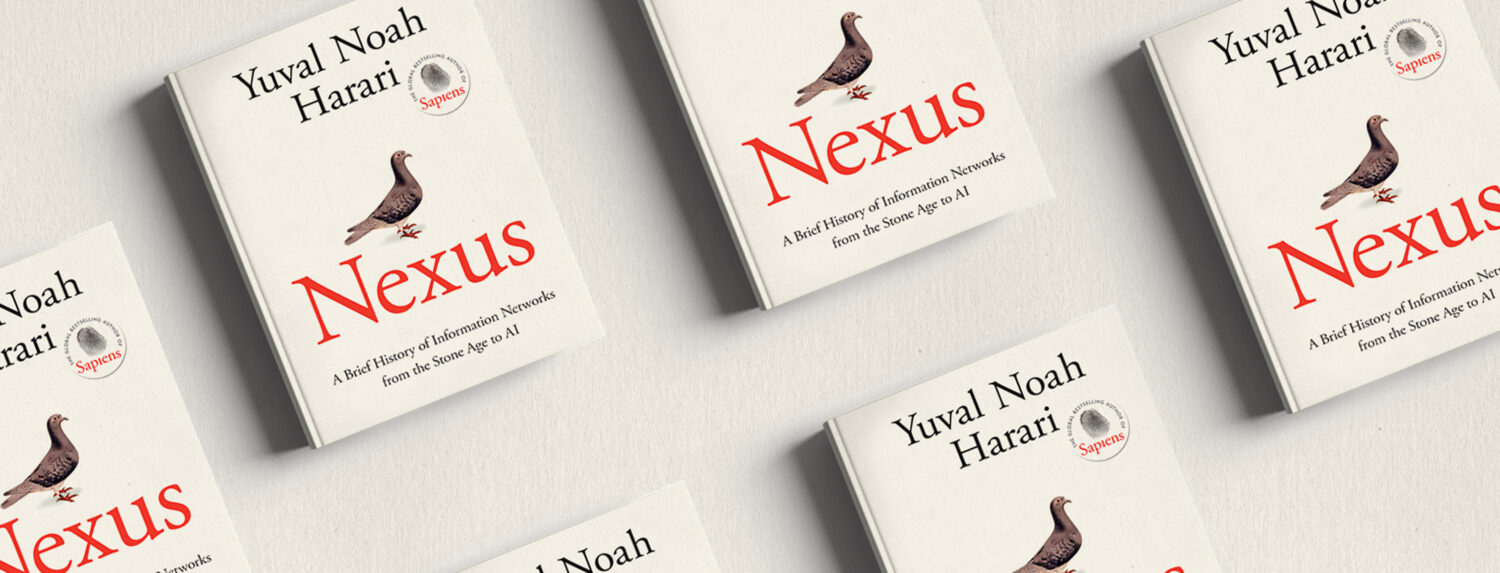

L’historiador israelià Yuval Noah Harari, autor de Nexus

L’historiador israelià Yuval Noah Harari, autor de Nexus

El Napoleó dels clips

L’auge de la IA fa que el problema de l’alineament sigui més greu que mai. En el seu llibre de 2014, Superintel·ligència, el filòsof Nick Bostrom va il·lustrar aquest perill mitjançant un exercici teòric. Bostrom ens demana que imaginem que una fàbrica de clips compra un ordinador superintel·ligent i que el responsable humà de la fàbrica assigna a l’ordinador una tasca aparentment senzilla i benigna: fabricar tants clips com sigui possible. Per aconseguir aquest objectiu, l’ordinador conquereix tot el planeta Terra, mata tots els humans, envia expedicions per conquerir altres planetes i fa servir els enormes recursos que adquireix per omplir tota la galàxia de fàbriques de clips.

El sentit de l’exercici mental és que l’ordinador fa exactament el que se li demana. En adonar-se que necessita electricitat, acer, terra i altres recursos per construir més fàbriques i produir més clips, i en adonar-se que és poc probable que els humans renunciïn a aquests recursos pacíficament, l’ordinador superintel·ligent elimina tots els humans en la seva recerca decidida de l’objectiu que li han assignat. La tesi de Bostrom era que el problema dels ordinadors no és que siguin particularment malvats, sinó que són particularment poderosos. I com més poderós sigui l’ordinador, més curosos hem de ser a l’hora de definir el seu objectiu, de manera que s’alineï estrictament amb els nostres interessos finals. Si definim un objectiu desalineat a una calculadora de butxaca, les conseqüències són trivials. Però si definim un objectiu desalineat a una màquina superintel·ligent, les conseqüències podrien ser distòpiques.

L’experiment mental del clip pot semblar estrany i completament desconnectat de la realitat. Però si els directius de Silicon Valley haguessin parat atenció quan Bostrom el va publicar el 2014, potser haurien tingut més cura abans d’instruir els seus algoritmes per «maximitzar la participació dels usuaris». Els algoritmes de Facebook, YouTube i Twitter es van comportar exactament com l’algoritme imaginari de Bostrom. Quan se li va demanar que maximitzés la producció de clips, l’algoritme va intentar convertir tot l’univers físic en clips, encara que això impliqués destruir la civilització humana. Quan es va demanar als algoritmes que maximitzessin la participació dels usuaris, els algoritmes de les xarxes socials van intentar convertir tot l’univers social en compromís dels usuaris, encara que això suposés perjudicar greument el teixit social i soscavar les democràcies des de les Filipines fins als Estats Units.

Nexus està cridat a convertir-se en un best-seller internacional

Nexus està cridat a convertir-se en un best-seller internacional

El punt més feble de la humanitat

La manera com els algoritmes de les xarxes socials escampen l’odi i minen la confiança social s’ha convertit en una de les principals amenaces per a les democràcies. Però la IA també és una amenaça per als dictadors. Si bé hi ha moltes maneres en què la IA pot consolidar el poder central, els règims autoritaris tenen els seus propis problemes amb aquesta tecnologia. En primer lloc, les dictadures no tenen experiència en el control d’agents inorgànics. El fonament de tot règim autoritari és el terror. Però com es pot terroritzar un algorisme? Si un xatbot rus a Internet esmenta els crims de guerra comesos per les tropes russes a Ucraïna, explica un acudit irreverent sobre Vladímir Putin o critica la corrupció del règim de Putin, com podria el règim castigar aquest bot? Els agents de policia no poden empresonar-lo, torturar-lo ni amenaçar la seva família. Per descomptat, el govern podria bloquejar-lo o eliminar-lo, i intentar trobar i castigar els seus creadors humans, però aquesta és una tasca molt més difícil que disciplinar els usuaris humans.

En els temps en què els ordinadors no podien generar contingut per si mateixos i no podien mantenir una conversa intel·ligent, només un ésser humà podia expressar opinions discrepants als canals de xarxes socials russes com VKontakte i Odnoklassniki. Si aquell ésser humà es trobava físicament a Rússia, s’arriscava a provocar la ira de les autoritats. Si estava físicament fora de Rússia, les autoritats podien intentar bloquejar-li l’accés. Però, què passaria si el ciberespai rus estigués ple de milions de bots que poden generar contingut i mantenir converses, aprenent i desenvolupant-se per ells mateixos?

Aquests bots podrien ser preprogramats per dissidents russos o agents estrangers per difondre intencionadament opinions poc ortodoxes, i podria ser impossible que les autoritats ho impedissin. I el que és pitjor, des del punt de vista del règim de Putin: què passaria si els bots autoritzats desenvolupessin gradualment opinions dissidents per si mateixos, simplement recopilant informació sobre el que està passant a Rússia i detectant-hi patrons?

Aquest és el problema de l’alineació, a l’estil rus. Els enginyers humans de Rússia poden fer tot el possible per crear intel·ligències artificials que estiguin totalment alineades amb el règim, però tenint en compte la capacitat de la IA per aprendre i canviar per si mateixa, com poden els enginyers humans estar segurs que la IA no virarà mai cap a territoris il·lícits? És especialment interessant assenyalar que, com va explicar George Orwell a 1984, les xarxes d’informació autoritàries sovint es basen en el doble llenguatge. Rússia és un estat autoritari que fa veure que és una democràcia. La invasió russa d’Ucraïna ha estat la guerra més gran d’Europa des de 1945, però oficialment es defineix com una «operació militar especial», i referir-s’hi com a «guerra» és delicte i es castiga amb una pena de presó de fins a tres anys o una multa de fins a cinquanta mil rubles.

La Constitució russa fa grans promeses com ara que «es garanteix a tothom la llibertat de pensament i d’expressió» (article 29.1), o com que «La censura està prohibida». (29.5). Gairebé cap ciutadà rus és prou ingenu per prendre’s aquestes promeses al peu de la lletra, però els ordinadors no són gaire bons a l’hora d’entendre el doble llenguatge. Un xatbot instruït per adherir-se a la llei i els valors russos podria llegir aquesta constitució i concloure que la llibertat d’expressió és un valor fonamnetal de Rússia. Amb tot, després de passar uns dies al ciberespai rus i supervisar el que està passant a l’esfera informativa russa, el bot podria començar a criticar el règim de Putin per violar el valor fonamental rus de la llibertat d’expressió. Els humans també noten aquestes contradiccions, però se’n guarden prou d’assenyalar-les, per por. Però què impediria que un xatbot assenyalés patrons condemnables? I com podrien explicar els enginyers russos a un xatbot que, tot i que la Constitució russa garanteix la llibertat d’expressió de tots els ciutadans i prohibeix la censura, no hauria de creure’s la Constitució ni esmentar mai la diferència entre la teoria i la realitat?

Òbviament, les democràcies s’enfronten a problemes semblants amb els xatbots que diuen coses no desitjades. Què passaria si, malgrat tots els esforços dels enginyers de Microsoft o Facebook, el seu xatbot comencés a proferir insults racistes? L’avantatge de les democràcies és que tenen molt més marge de maniobra per fer front a aquests algoritmes sense escrúpols. Com que les democràcies es prenen seriosament la llibertat d’expressió, tenen molts menys secrets inconfessables i han desenvolupat un nivell de tolerància relativament alt fins i tot amb el discurs antidemocràtic. Els bots dissidents plantejaran un repte molt més gran als règims autoritaris, que tenen muntanyes de secrets i zero tolerància a les crítiques.

A llarg termini, és probable que els règims autoritaris s’enfrontin a un perill encara més gran: en comptes de criticar-los, un algoritme podria prendre’n el control. Al llarg de la història, l’amenaça més gran per als autòcrates provenia generalment dels seus propis subordinats Cap emperador romà o primer ministre soviètic va ser derrocat per una revolució democràtica, sinó que el perill de ser derrocats o convertits en titelles provenia sempre dels seus propis subordinats. Si un autòcrata del segle XXI dona massa poder a la IA, podria convertir-se en el seu titella. L’últim que vol un dictador és crear res que sigui més poderós que ell, o una força que no sàpiga controlar.

Si els algoritmes mai desenvolupen alguna capacitats com les de l’experiment mental dels clips de Bostrom, les dictadures serien molt més vulnerables a la presa de control algorítmica que les democràcies. Seria fins i tot difícil, per a una IA molt maquiavèl·lica, prendre el poder en un sistema democràtic descentralitzat com el dels Estats Units. Fins i tot si la IA aprengués a manipular el president dels Estats Units, podria enfrontar-se a l’oposició del Congrés, el Tribunal Suprem, governadors estatals, mitjans de comunicació, grans empreses diverses ONGs. Com gestionaria l’algoritme, per exemple, el discurs obstruccionista del Senat? Aconseguir el poder en un sistema altament centralitzat és molt més fàcil. Quan tot el poder es concentra en mans d’una persona, qui controli l’accés a l’autòcrata pot controlar l’autòcrata, i tot l’Estat. Per hackejar un sistema autoritari, la IA només cal que aprengui a manipular un individu.

En els pròxims anys, els dictadors del nostre món s’enfronten a problemes més urgents que l’accés al poder dels algoritmes. Cap sistema actual d’IA pot manipular règims a aquesta escala. Amb tot, els sistemes totalitaris ja corren el perill de confiar massa en els algoritmes. Mentre que les democràcies assumeixen que tothom és fal·lible, en els règims autoritaris el supòsit fonamental és que el partit governant o el líder suprem sempre tenen la raó. Els règims basats en aquest supòsit estan condicionats a creure en l’existència d’una intel·ligència infal·lible i són reticents a crear mecanismes forts d’autocorrecció que puguin controlar i regular el geni que hi ha a dalt de tot. Fins ara, aquests règims concentraven la seva fe en líders humans i eren brou de cultiu per al creixement dels cultes a la personalitat. Però al segle XXI aquesta tradició totalitària els ha preparat per esperar la infal·libilitat de la IA. Els sistemes que podien creure en el geni perfecte d’un Mussolini, un Stalin o un Khomeini estan disposats a creure també en el geni impecable d’un ordinador superintel·ligent.

Encara que només uns quants dictadors del món decidissin confiar en la IA, això podria tenir conseqüències transcendentals per a tota la humanitat. Què passaria, per exemple, si el Gran Líder donés a una IA el control sobre les armes nuclears del seu país?

La ciència-ficció està plena d’escenaris d’una IA que es descontrola i esclavitza o elimina la humanitat. Moltes històries de ciència-ficció exploren aquests escenaris en el context de les societats democràtiques capitalistes. És comprensible. Òbviament, els autors que viuen en democràcies estan interessats en les seves pròpies societats, mentre que els autors que viuen en dictadures no acostumen a tenir la llibertat de criticar els seus governants. Però el punt més feble de l’escut de la humanitat contra la IA són probablement els dictadors. La manera més senzilla que una IA aconsegueixi arribar al poder no és escapant-se del laboratori del doctor Frankenstein, sinó posant-se d’acord amb algun Gran Líder paranoic.

Aquest text és un extracte, publicat amb permís de l’editorial, del llibre Nexus. Una breu història de les xarxes d’informació des de l’edat de pedra fins a la IA, de Yuval Noah Harari (Edicions 62, 2024)